近日,我院陈震中教授指导的智能信息处理课题组(iip.whu.edu.cn)博士生欧阳君及硕士生米黎合作论文“Object-Relation Reasoning Graph for Action Recognition” 被国际计算机视觉顶级会议CVPR录用。

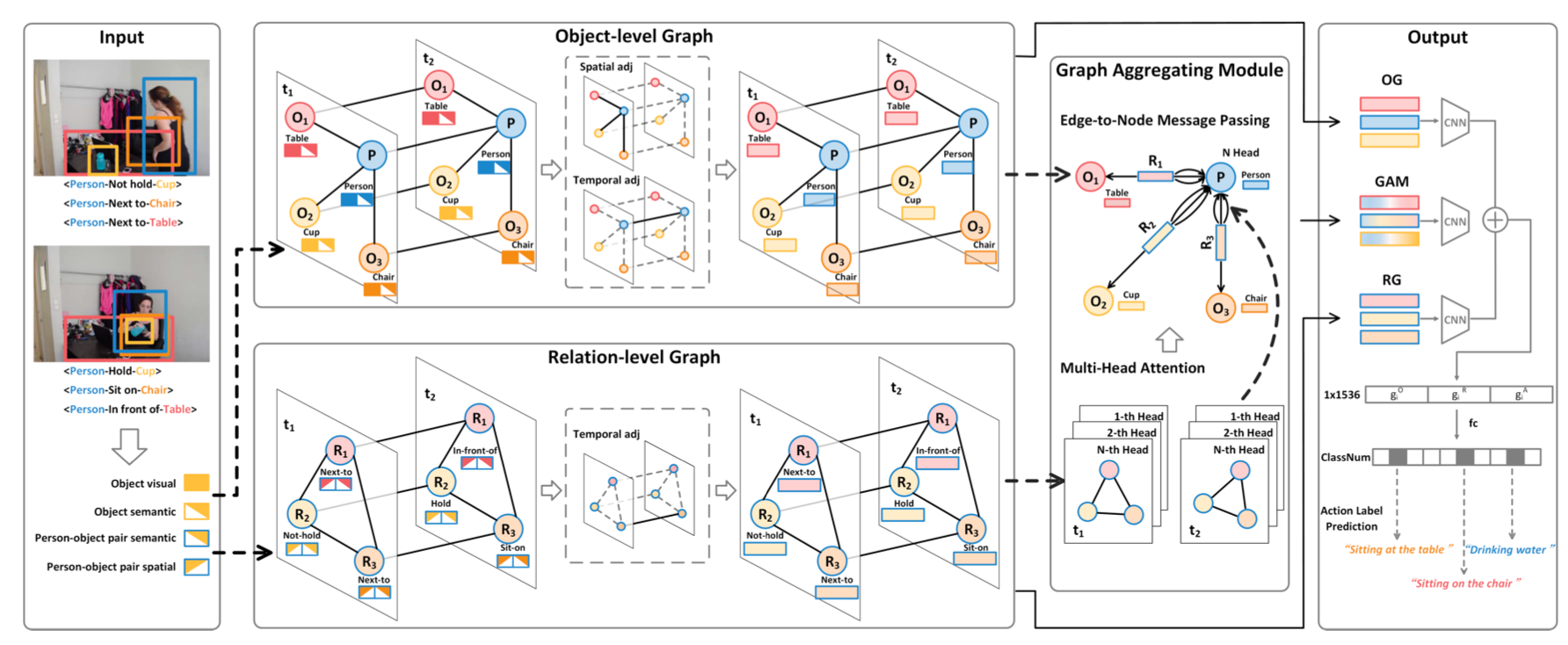

动作识别是视频理解领域的一项重要的研究课题。相比图像而言,视频内容和背景更加复杂多变,视频中目标的属性及目标之间的关系随着时间不断变化,为动作识别任务带来了挑战性。本文提出的目标关系推理图卷积网络(OR2G)从可解释性的角度对动作进行推理,通过将动作分解为一系列时序的目标和关系,构建目标级别图和关系级别图分别对时序目标和关系进行推理,并利用图聚合模块将关系图节点信息反向更新回目标图,以增加两个图之间的耦合性。在Action Genome数据集上,相比于传统方法获得了较大的性能提升,促进动作识别任务向基于语义推理的方向发展。

图1: 目标关系推理图卷积网络OR2G

此外,陈震中教授课题组博士生胡姚姒与微软亚洲研究院智能多媒体组的实习合作论文“Make It Move: Controllable Image-to-Video Generation with Text Descriptions”也被CVPR录用。

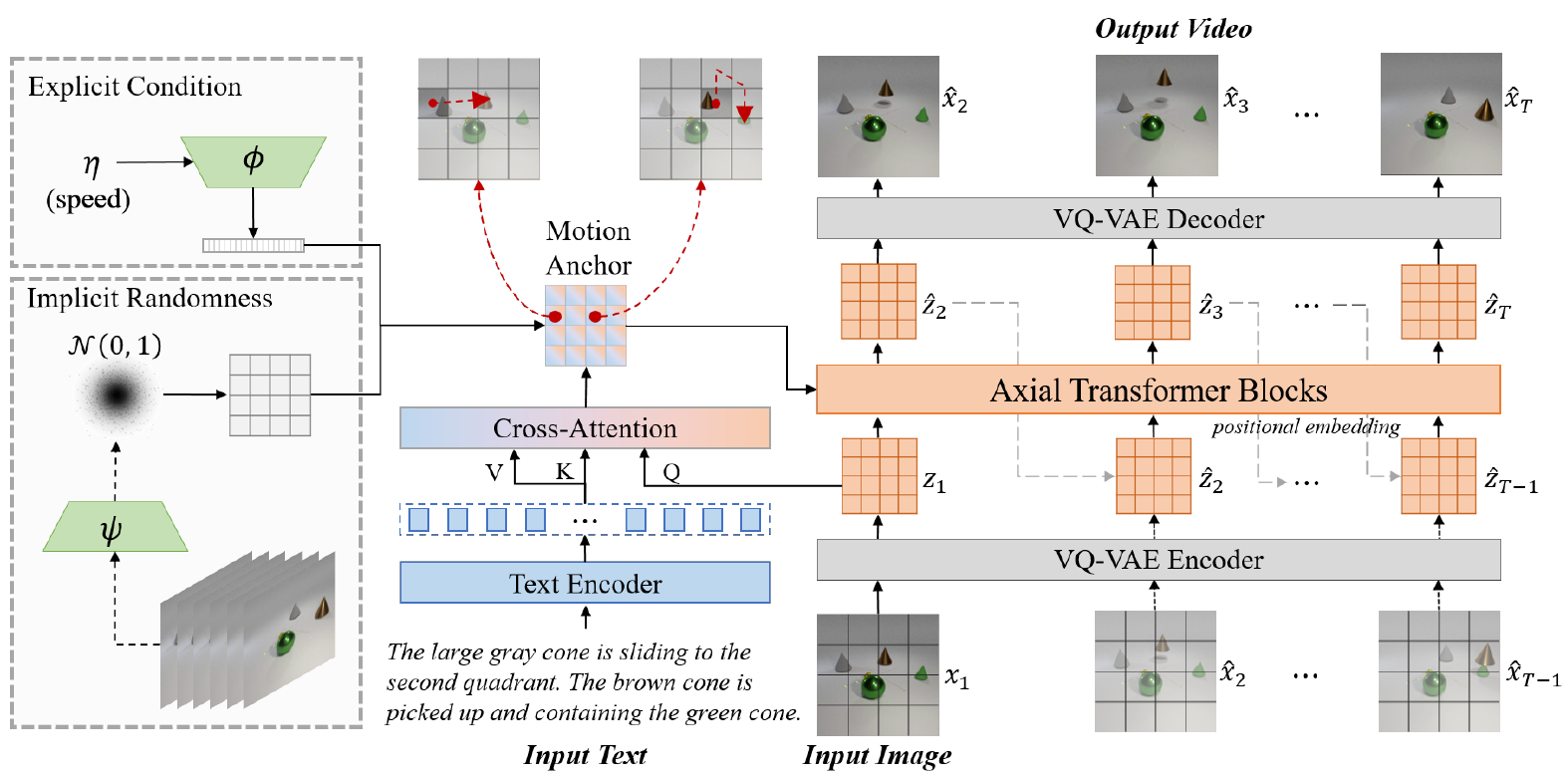

该论文针对视频生成这一计算机视觉领域极具挑战性的课题,提出了一种新颖的文本图像驱动的视频生成任务(Text-Image-to-Video generation,TI2V),并实现了一种基于运动锚点的视频自回归生成模型。通过运动描点实现图像与文本的语义对齐,并以时空对齐的方式驱动视频生成。同时,该模型通过引入显式条件以及隐式随机噪声,分别实现对视频速度控制以及模糊文本的多样化视频生成。该工作构建了针对TI2V任务的CATER-GENs数据集,验证了这一任务的可行性与模型的有效性,推动了可控视频生成领域的发展。

陈震中教授课题组多名研究生在与该组的实习合作期间均有高水平期刊会议论文发表,我院学生的科研能力得到了一致好评。

图2: 基于运动锚点的视频生成模型MAGE