近日,人工智能领域国际顶级期刊《IEEE Transactions on Pattern Analysis and Machine Intelligence》(IEEE TPAMI,影响因子:20.8)在线发表了武汉大学遥感信息工程学院李彦胜课题组关于大幅面遥感影像场景图生成的最新研究成果,研究成果在张永军教授的指导下完成。论文题为STAR: A First-Ever Dataset and A Large-Scale Benchmark for Scene Graph Generation in Large-Size Satellite Imagery,合作者包括武汉大学、上海交大、西工大、中科院空天院、美国康奈尔大学、中南大学等国内外机构的知名学者及研究生。论文公开了大幅面遥感影像场景图生成样本库、算法工具包及评测排行榜,提出了一种适用于大幅面遥感影像目标检测及关系预测的新方法。

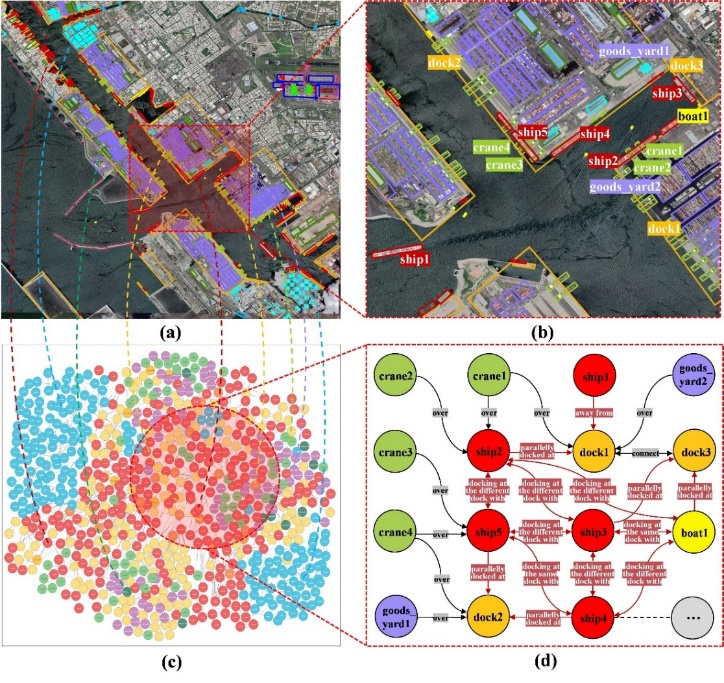

图 1. 大幅面遥感影像场景图生成示意图。(a)和(c)分别展示了显示大幅面遥感影像中目标检测和场景图生成结果,(b)和(d)为对应的局部细节展示。在(d)中,黑色箭头表示仅依赖于孤立目标对可预测的关系,而红色箭头表示需要借助上下文推断的复杂关系。

遥感影像场景图生成有助于促进复杂地理空间从场景感知到场景认知的升级跃迁。在大幅面遥感影像中,地理目标的尺度和纵横比变化大,地理目标之间(甚至是空间不相交的地理目标之间)存在丰富语义关系,这使得在大幅面遥感影像中进行整体场景图生成十分必要。然而,大幅面遥感影像场景图生成样本库的缺乏极大限制了遥感影像认知技术发展。由于大幅面遥感影像复杂度高,挖掘目标-关系三元组<目标,关系,目标>高度依赖远距离上下文推理。传统为小尺寸自然图像设计的场景图生成模型无法直接适用于大幅面遥感影像。因此,亟需建设大幅面遥感影像场景图生成样本库,发展全新大幅面遥感影像场景图生成理论方法。

在样本库建设方面,论文构建了一套面向全球采样的大幅面遥感影像场景图生成样本库STAR(涵盖了全球范围内与人类活动密切相关的11类复杂地理空间场景如机场、港口、核电站、火电站、风力发电站、水坝和服务区、立交桥、水面桥、施工工地和体育运动场景等,人工精细标注超过210,000个地理目标和超过400,000个目标-关系三元组,影像幅面为512×768到27,860×31,096像素)。STAR样本库可以为大幅面遥感影像目标检测和场景图生成任务提供有力数据支撑。

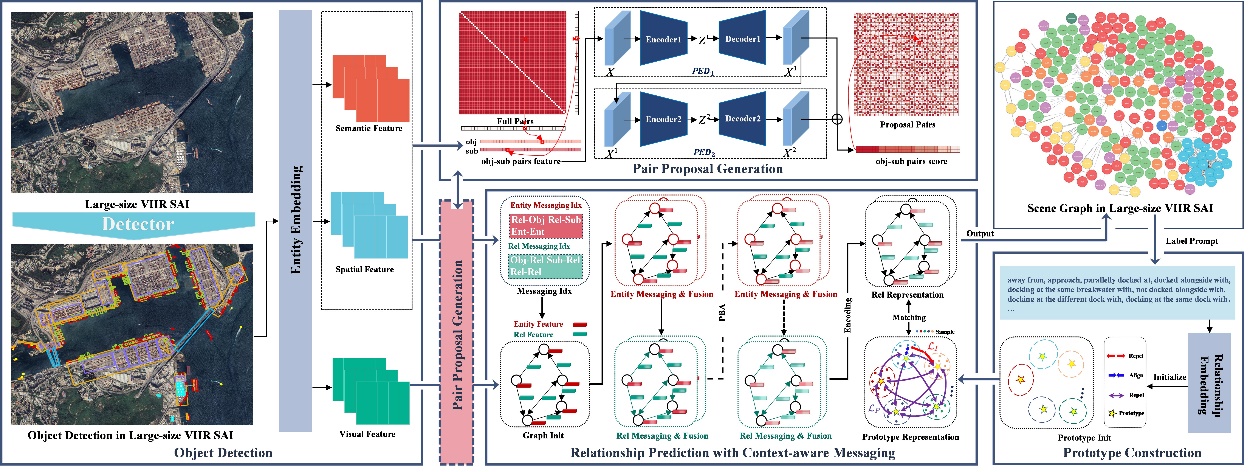

在方法探索方面,论文提出了一种基于全局上下文感知的大幅面遥感影像场景图生成方法:从目标检测、目标对剪枝和关系预测三个层面逐级渐进解析大幅面复杂遥感影像。具体地,提出了能够灵活集成多尺度上下文的整体多类目标检测方法,检测大幅面遥感影像中的目标;设计了基于对抗-重构的关系候选对生成方法,筛选包含高价值关系的目标对;提出了带有上下文感知消息传递的关系预测方法,预测候选对的关系类型。

图 2. 基于全局上下文感知的大幅面遥感影像场景图生成方法

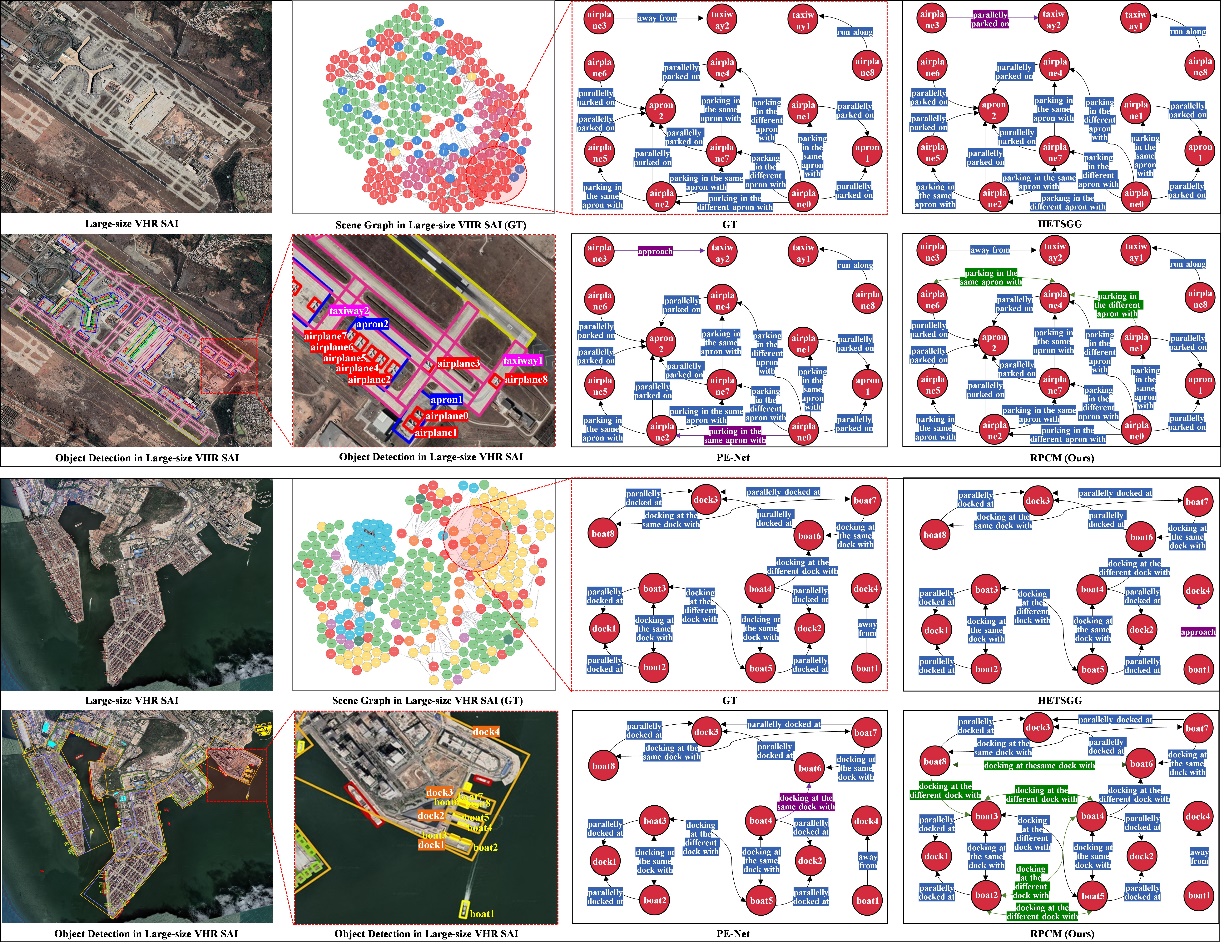

在评估基准构建方面,针对面向水平框和旋转框的大幅面遥感影像目标检测与场景图生成任务,发布了面向大幅面遥感影像的场景图生成算法工具包(包含30余种目标检测方法和10余种场景图生成方法)。依托STAR样本库,进行了全面基准测试,实验表明提出的新方法相比基线方法具有明显性能优势。

图 3. 论文提出新方法与现有方法在STAR数据集上的场景图生成结果可视化对比

该项研究得到国家自然科学基金重点项目(资助编号:42030102)和面上项目(资助编号:42371321)资助支持。

项目链接:https://linlin-dev.github.io/project/STAR

论文链接:https://ieeexplore.ieee.org/abstract/document/10770756